Python으로 딥러닝하기|자연어 3. Seq2Seq, Attention

Python으로 딥러닝하기|자연어 처리 1. 토크나이징

Python으로 딥러닝하기|자연어 2. 단어 임베딩, Word2Vec

Python으로 딥러닝하기|RNN(Recurrent Neural Networks) Part1. 이론

Python으로 딥러닝하기|LSTM(RNN) Part1&2. 이론 및 실습

잠시 미뤄왔던 자연어처리 시리즈를 다시 작성해보고자 합니다... 화이팅!

seq2seq paper: Sequence to Sequence Learning with Neural Networks

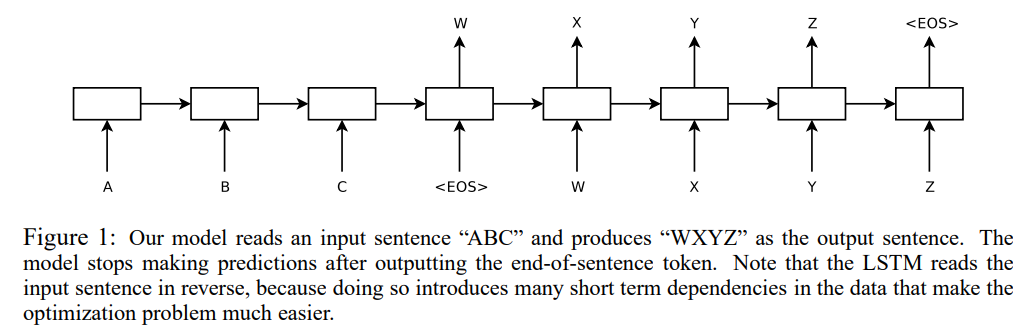

우선 Sequence to Sequence(Seq2Seq) 모델은 RNN의 many-to-many 와 유사한 구조로 시퀀스 형태의 입력값을 넣으면 시퀀스 형태의 출력값을 내놓는 구조입니다. 따라서 번역, 요약, 챗봇 등 다양한 분야에서 활용될 수 있습니다.

RNN(LSTM) 모델을 기반으로 Encoder와 Decoder 부분이 나눠져 있습니다. Encoder에서는 입력값의 context vector(=hidden status)를 생성하고 Decoder에서는 해당 vector를 활용해 재귀적으로 출력값을 만들어내는 구조입니다.

그리고 Encoder와 Decoder는 길이가 고정되어있지만, 각각 다른 최대 길이를 가질 수 있고, 데이터의 길이가 적으면 Padding으로 채웁니다.

RNN의 many-to-many 와 유사한 구조라고 이야기했는데, Decoder에서 다른 부분이 존재합니다.

우선 Seq2Seq 구조의 경우 <EOS> 혹은 <START>, <END> 라는 토큰을 활용하여 시작과 끝맺음을 할 수 있도록 데이터를 구성하여 훈련할 수 있습니다. (참고: 최대 길이보다 길이가 짧은 경우 <END> 토큰 이후에 Padding으로 채우는 방식)

또한 "재귀적"으로 훈련된다는 점도 다릅니다. Decoder의 현재 cell(층)의 input은 이전 cell의 output을 활용하는 것으로 구성되어 있습니다. (RNN은 context vector 하나만 사용)

여기서 만약 Decoder가 시작부터 틀린다면 학습이 잘 되지 않을 수 있습니다. 따라서 Decoder의 현재 cell의 input 값을 실제(정답) 데이터로 사용하는 Teacher Forcing이라는 새로운 학습 방법이 제안됩니다.

Transformer paper: Attention Is All You Need

이후에 Transformer를 설명할 것인데, 이를 이해하기 위해서는 논문의 제목에서도 알 수 있듯, Attention이라는 개념을 먼저 알아야합니다.

Attention 매커니즘은 고정된 크기의 context vector를 사용하는 Seq2Seq를 개선하는 방법으로 아래의 그림을 참고해서 보면 Attention의 뜻을 짐작해 볼 수 있습니다.

1. Encoder에서 모든 cell(층)의 hidden status와 Decoder의 현재 cell의 hidden satus와 dot product를 하여 attention scores를 생성

2. softmax에 통과시켜 가중합을 한 attention value를 구하고 Decoder에서 현재 cell의 output 값과 concatenate하여 다음 값을 예측

이러한 과정을 통해 Encoder 부분의 어떤 hidden status에 더 "집중"하면 좋은지를 학습할 수 있습니다.

Attention 식은 매우 간단합니다. 아래의 식은 Scaled Dot-Product Attention Score입니다.

$\text{attention score}(s_t, h_i) = \frac{s_t^Th_i}{\sqrt{n}}$

$s_t$: Decoder의 현재 hidden status

$h_i$: Encoder의 i번째 hidden status

Transformer도 할 내용이 많아서.. 다시 돌아오겠습니다.